Unser Erfahrungsbericht aus der SAP Datasphere

Zwar verfügte die SAP mit der Analytics Cloud und der Analytics Cloud for Planning über Werkzeuge für Datenanalyse und Planung in der Cloud, allerdings ohne nennenswerte Funktionen für das Datenmanagement. Genau diese Lücke soll nun die SAP Datasphere im Cloud-Angebot der SAP schließen. Abbildung 1: Die SAP Cloud Familie für Business Intelligence

Abbildung 1: Die SAP Cloud Familie für Business Intelligence

Wir möchten Ihnen vorstellen, wie Daten aus einem SAP Quellsystem in der Datasphere konsumiert werden können und welche Schritte zu erledigen sind, bis die Datenverbindung eingerichtet ist. Dann zeigen wir, wie einfach es ist, mit einem externen Werkzeug, wie in unserem Beispiel PowerBI, darauf zuzugreifen. Anschließend gehen wir darauf ein, wie Daten mit dem bereitgestellten Excel Add-In verwendet werden können. Eine für Daten-Profis sicher spannende Option ist die Zugriffsmöglichkeit über Jupyter Notebooks und Pandas Dataframe. Wir haben uns die Möglichkeiten angeschaut, die durch die Option SAP BW Bridge für SAP BW Nutzer entstehen.

Wenn Sie mehr an einer Funktionsübersicht, Anwendungsfälle und der allgemeinen Positionierung der SAP Datasphere erfahren möchten, empfehlen wir Ihnen unsere Themenseite, sowie den Download unseres Whitepapers.

Datenbereitstellung in Spaces

Als zentrales Datenzugriffssystem ermöglicht die SAP Datasphere die unternehmensweite Bereitstellung der Daten in einem semantischen Layer. Daneben aber auch das Extrahieren, Transformieren und die Datenhaltung. Dafür können die Nutzer aus vielen Konnektoren zu verschiedenen SAP-Produkten und NON-SAP Produkten wählen. Die Bereitstellung eines Open Connectors macht es zudem möglich, jedes gewünschte Produkt an die Data Datasphere anzubinden. Es folgt zudem dem Trend des Low-Code Ansatzes, den viele Hersteller u.a. Microsoft mit der Power Plattform schon heute seinen Nutzern zur Verfügung stellt.

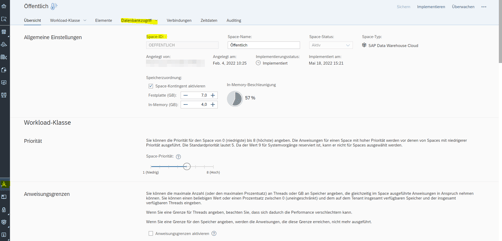

Daten werden in einen sogenannten Space geladen. Dieser ermöglicht es den Fachabteilungen, selbst Daten aufzubereiten und anderen Nutzern zur Verfügung zu stellen. Daten können aus CSV-Dateien, aus SAP- und NON-SAP Produkten, sowie freigegebene Datentabellen und Views aus anderen Spaces geladen werden. Hierfür bietet die Datasphere vorinstallierte Konnektoren, aus denen der Nutzer auswählen kann. Zu SAP-Systemen stehen dabei 13 vorinstallierte Konnektoren zur Verfügung. Hier kann bspw. eine Verbindung zu einem SAP BW On-Premise System hergestellt werden.

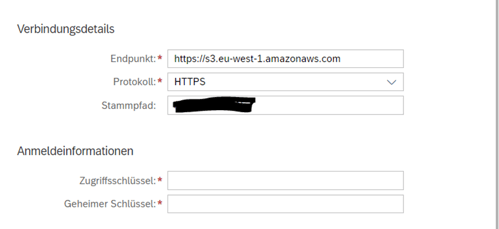

Für bestimmte On-Premise Verbindungen ist der Einsatz des SAP-Cloud Connector nötig. Dieser ermöglicht eine sichere Verbindung und den Zugriff auf Remote Tabellen und File-Ablagen. Zu nicht SAP-Produkten stehen dem Kunden Konnektoren zu Microsoft Azure, AWS, Google Cloud sowie Open Source Datenbanken wie Hadoop zur Verfügung. Zukünftig möchte die SAP die Produktspanne der NON SAP-Produkte noch erweitern. Für spezielle Konnektoren kann ebenfalls eine SAP Open Connector verwendet werden. Hier stehen weitere Konnektoren, wie bspw. ein Twitter(heute X)-Konnektor, standardmäßig zur Verfügung. Als Beispiel wurde eine Verbindung zu einem S3 Bucket mittels Open Connector und mittels integriertem Connector der Datasphere hergestellt. Für beide Verbindungen benötigt der User einen privaten und Zugriffsschlüssel. Dies bedeutet, dass für den Zugriff zwingend ein Account für einen User angelegt sein muss, der sich mit dem S3 Bucket verbinden möchte. In Abbildung 2 wird eine solche Connection dargestellt.

Abbildung 2: Connection zu einem S3 Bucket

Der Verbindung sind dabei der Endpunkt, also nur Standort, an dem der S3 Bucket liegt, sowie der Stammpfad, also der weitere Pfad, mitzugeben, an dem die benötigten Daten abgelegt sind. Aus der Kombination aus Zugriffsschlüssel und geheimer Schlüssel wird der Zugriff gewährt. Daten können dann ausschließlich in einem Datenfluss, im Data Builder, in die Datasphere geladen werden.

Zu beachten gibt es hier: Die genannten Konnektoren können nur dazu verwendet werden, Daten in die SAP Datasphere zu laden, diese aber nicht, für bspw. Klassifikation mit Tensorflow in einem AWS Stack, nach außen zu geben. Dies ist nicht über die Cloud-Konnektoren möglich, ist aber über andere Komponenten der Datasphere, durchaus realisierbar.

Für zwei weitere Komponenten, Oracle Database on Premise und Amazon Redshift, muss der SAP Datasphere zusätzlich ein Treiber mitgegeben werden. Wichtig: Nur die in der Dokumentation genannten Treiber werden unterstützt. Die Dokumentation zu diesen Treibern finden Sie hier.

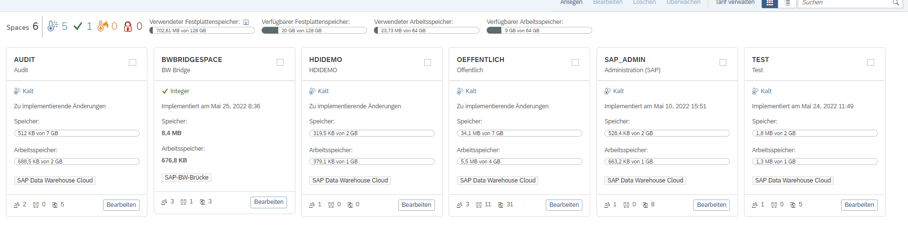

Der zugeteilte Speicherplatz, der dem Space zur Verfügung steht, ist individuell einstellbar. Ist der Space voll, wird der Space auf gesperrt gesetzt. Er muss dann von einem Administrator wieder freigegeben werden. In diesem Fall bleiben 24h, bis dieser wieder gesperrt wird, außer:

-

Dem Space wird mehr Speicher zugeordnet

-

Tabellen werden gelöscht

Abbildung 3: Space Management eine Übersicht über alle Spaces.

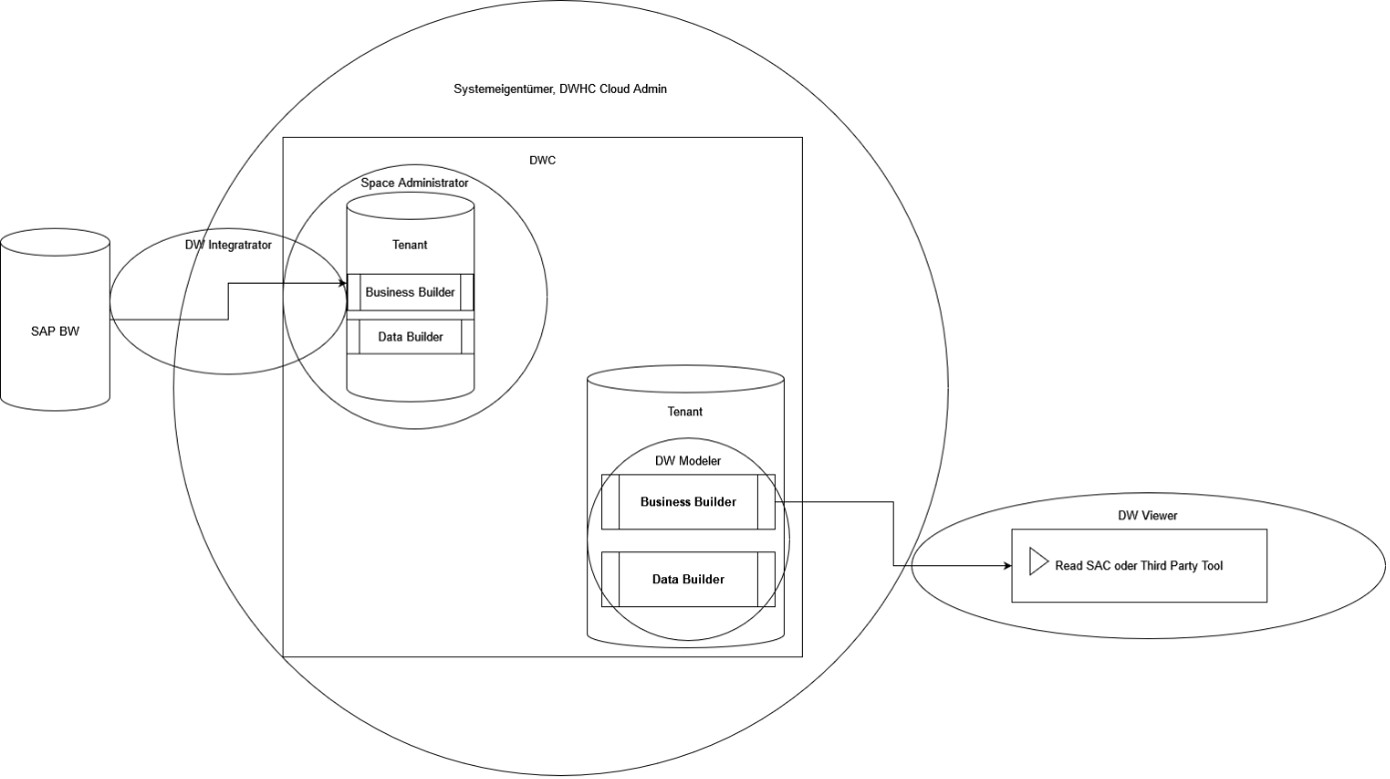

Data Security mittels User Rollen

Mittels Vergabe von User Rollen kann der Zugriff innerhalb der SAP Datasphere, sowie ebenfalls innerhalb der Spaces, indem der User zugeordnet ist, eingeschränkt werden.

Vollzugriff auf die komplette Datasphere ist dem Systemeigentümer, sowie dem DW Administrator vorbehalten. Sie können uneingeschränkt Spaces und Nutzer anlegen, sowie auf jedem Space zugreifen. Zusätzlich ist dem Systemeigentümer das Recht vorbehalten, die SAP Datasphere bei der SAP zu kündigen.

Innerhalb der Spaces kann eine Space Administratoren Rolle vergeben werden. Sie greift nur für die Spaces, in denen der User zugeordnet ist. Neben der kompletten Administration der Spaces, kann eine weitere technische Rolle vergeben werden, die des DW Integrators. Dieser hat die Berechtigung dazu, Verbindungen zu SAP oder NON-SAP Produkten herzustellen, sowie HDI-Container und für 3rd Party BI Tools, eigene Datenbankbenutzer anzulegen.

Für die Modellierung der Daten kann die Rolle des DW Modeler gewählt werden. Dieser hat uneingeschränkten Zugriff auf den Data- und Business Modeler und kann dort neue Modelle anlegen oder Modelle bearbeiten.

Für jeden Space können dazu nochmals zwei reine Consumer Rollen angelegt werden. Der DW Viewer hat die Möglichkeit, Objekte im Space anzuzeigen. Der DW Consumer kann mittels SAC oder einem 3rd Party Tool, wie bspw. Power BI, auf die freigebenden Modelle und Daten des Space zugreifen. Jedoch hat er keine Berechtigung, sich auf der SAP Datasphere anzumelden.

Abbildung 4: Rollenverteilung und Standardzugriffe der Data Warehouse Cloud

Abbildung 4: Rollenverteilung und Standardzugriffe der Data Warehouse Cloud

Aufbereitung der Daten mit dem Data Builder

Zur Datenaufbereitung bietet die SAP Datasphere mit dem Data Builder ein eigenes Werkzeug, das in jedem Space verfügbar ist. Im Data Builder wird dabei für jede Eingangstabelle eine neue Tabelle erzeugt. Der User kann dabei selbst bestimmen, wie häufig die Daten benötigt werden. Bei häufigen Datenzugriffen auf eine Tabelle kann diese wahlweise direkt im In-Memory, also im Hana Speicher der Datasphere, gehalten werden oder ist im SSD Speicher auszulagern. Dies gilt auch für Remote-Tabellen. Hier wird ein Stand in die Datasphere geladen. Diese können entweder per Zeitplan oder manuell mit neuen Daten versorgt werden. Aber was passiert, wenn die Quelle geändert wird?

Da die Tabellenstruktur bereits angelegt ist, können Veränderungen in der Quelle dazu führen, dass keine Snapshots mehr geladen werden können. Dies ist der Fall, wenn eine oder mehrere Spalten ersetzt werden.

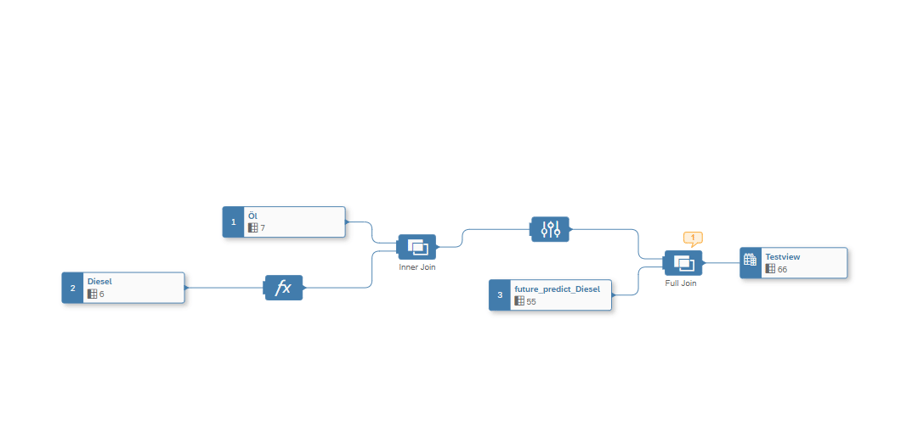

Tabellen können durch Nutzer weiterverwendet werden, indem diese Daten transformieren, Views mittels SQL Befehlen oder per Drag and Drop erzeugen. Analytische Views können direkt für die Verwendung freigegeben werden. Mittels Row-Level Security können Datenzugriffe auch innerhalb der Spaces eingeschränkt werden. Dies greift sogar bei Administratoren und Systemeigentümern. Sollte ein User also auf eine Tabelle zugreifen, in der eine Datenzugriffskontrolle wirkt, ist diese für ihn augenscheinlich leer. Abbildung 5: Beispiel Grafischer View

Abbildung 5: Beispiel Grafischer View

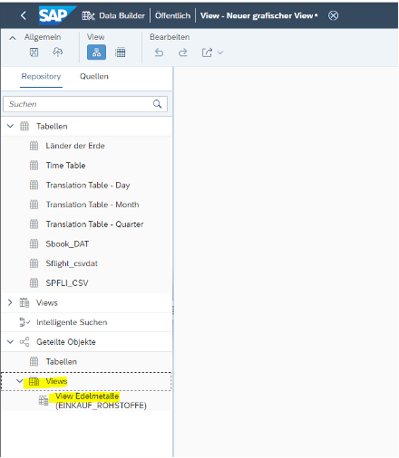

Freigabe und Sharing

Analytische Views können direkt mit oder ohne Datenzugriffskontrolle zur Verfügung gestellt werden. Tabellen mit Dimensions-Daten können als Dimensionen im Data Builder abgebildet werden. Tabellen oder Views mit analytischen Daten zu analytical Datasets. Im Verbrauchsmodell können Dimensionen und analytische Daten zusammengeführt werden. Tabellen und Views können wahlweise auch mit anderen Spaces geteilt werden. Sie sind dann für die anderen Spaces, im Data Builder, im View als neuer Ordner mit geteilten Objekten sichtbar.

Abbildung 6: geteiltes Objekt im Space

Durch eine Live-Verbindung in die SAC können diese Modelle in Storys und Analytic Applications importiert und verwendet werden. Eine Integration der Datasphere in Planungsmodelle ist aktuell von der SAP geplant, aber noch nicht realisiert. Um Modelle ohne Probleme in der SAC nutzen zu können, ist ein wenig Vorarbeit notwendig. Hier geht es im Grunde darum, die Produkte gegenseitig vertraut zu machen. Dazu muss erstmals von der SAP Datasphere in den Tenant der SAC gewechselt werden. Unter System->Administration->App Integration muss dabei die Datasphere als vertrauenswürdige Ursprungsadresse eingefügt werden.

Abbildung 7: Vertrauenswürdige Quellen zulassen

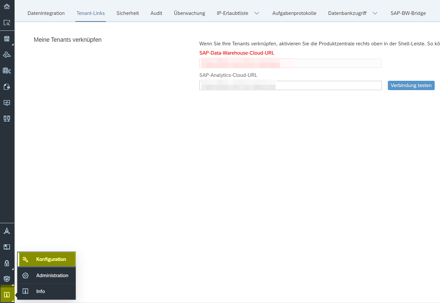

Die Ursprungsadresse, bzw. der Tenantlink der Datasphere, ist dabei in der Datasphere selbst, wie in Abbildung 10 dargestellt, zu finden.

Abbildung 8: Tenant Link der DWH finden

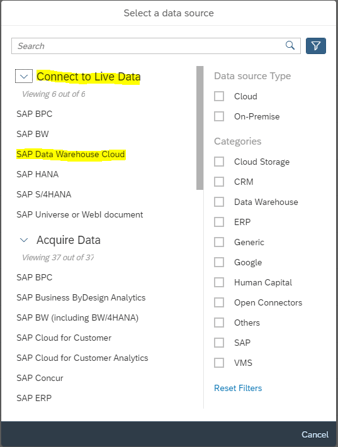

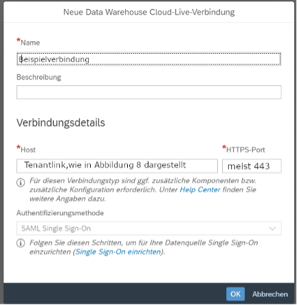

Nun kann eine Live-Verbindung zwischen den Systemen hergestellt werden. Hierfür wird in der SAC auf den Verbindungstab gewechselt und unter Neu eine Datasphere Verbindung, wie in Abbildung 9 und 10 dargestellt, hergestellt.

Abbildung 9: Neue Live-Verbindung - das Auswahlfeld der Konnektoren

Abbildung 10: Verbindungsmaske Datasphere

Nun können diese sowohl in Story als auch in Analytics Application als Datenquelle definiert werden. Dazu wird als Datenquelle: Daten aus Datenquelle verwendet. Indem die neue Datasphere Verbindung ausgewählt wird. Mittels der Authentifizierungsmethode Single Sign-On hat der Benutzer nur Zugriff auf die Spaces, in denen er selbst Mitglied ist, sowie auf Modelle und Daten, die für die Analyse freigegeben wurden.

Verbindung zu Drittanbieter Analyse-Tools

Power BI Desktop:Für die Verbindung mit Power BI werden zunächst zwei Pakete benötigt, die im SAP Support Launchpad für registrierte Nutzer zur Verfügung stehen. Es wird das Paket SAP HANA Client 2.0 (Version 10 oder höher) sowie die SAPCAR.exe für das entpackend der SAR Datei benötigt.

Es empfiehlt sich beide Dateien im selben Ordner zu downloaden, da für das Entpacken die Command Line von Windows notwendig ist und sonst der ganze Pfad der SAR Datei angegeben werden müsste.

Mittels Command Line wechseln wird nun in den Ordner, in dem die Dateien gedownloadet wurden, mittels Befehl: SAPCAR.EXE -xf <Datei>.SAR, wird die Datei entpackt.

Abbildung 11: Ordner mit Installationsfiles

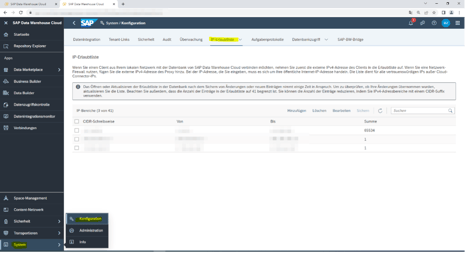

Durch Ausführen des Setups kann der benötigte HDBCI Treiber installiert werden. Danach muss die öffentliche IP-Adresse in der SAP Datasphere in der Erlaubnisliste mit aufgenommen werden, sodass eine Verbindung hergestellt werden kann. Ist die IP-Adresse nicht aufgenommen, wird die Verbindung von der Datasphere geblockt.

Abbildung 12: IP-Erlaubnisliste

Zusätzlich muss in der SAP Datasphere ein Datenbankbenutzer angelegt werden. Dies ist unter Space -> Datenbankbenutzer anlegen möglich:

Abbildung 13: Space-Administrationsübersicht

Der Nutzer kann sowohl mit Schreib- als auch nur mit Lesezugriff ausgestattet sein. In Abbildung 9 beispielsweise wurden für den User „TestJupyter“ Lese- und Schreibrechte zugeteilt, wobei der User PowerBI nur Lesezugriffe besitzt.

Abbildung 14: angelegte Datenbankbenutzer

Der Username, URL, Port und das Passwort können nach erneutem Implementieren des Spaces ausgelesen werden. Dies ist für den nächsten Schritt wichtig.

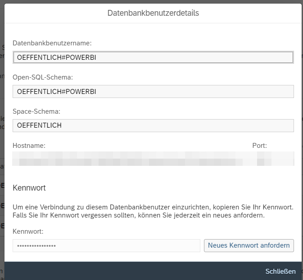

Abbildung 15: Anzeige des Benutzers

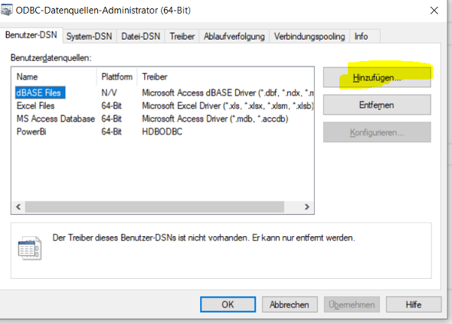

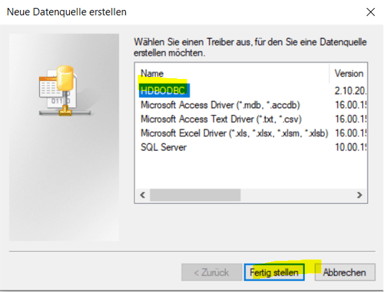

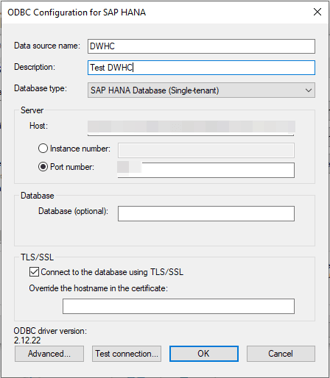

Im nächsten Schritt muss die neue HDBCI Verbindung in Windows angelegt werden. Dies wird mit dem vorinstallierten Programm ODBC-Datenquelle ermöglicht.

Abbildung 16: Startseite auf Hinzufügen

Abbildung 17: HDBODBC als Verbindung auswählen

Abbildung 18: Erstellungsmaske ODBC Driver (Wichtig: Database Type = Single-tenant, Host + Port=Host + Port des Datenbankbenutzers sowie TLS/SSL Connection ausgewählt

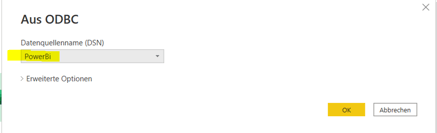

Wurde die Verbindung erstellt kann nun in PowerBI eine ODBC Verbindung angelegt werden. Hierzu wird im Reiter Daten->Datenabrufen->Weitere die ODBC Verbindung ausgewählt.

Abbildung 19: Auswahl der Verbindung

Die gerade angelegte Verbindung ist nun unter Datenquellen zu finden. Nach Bestätigung ist der Datenbankuser und das Kennwort für eine Anmeldung zu übermitteln.

Abbildung 20: Anmeldemaske DSN Verbindung

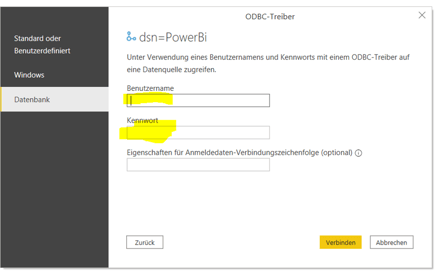

Anschließend wird der aus PowerBI bekannte Navigator aufgerufen, indem alle Verbindungen angezeigt werden. Es können dabei aber nur Datenmodelle und Views abgerufen werden, die für eine Verwendung vorgesehen sind. Ist ein angeklicktes Element nicht für den Verbrauch vorgesehen, wird eine Fehlermeldung angezeigt.

Abbildung 21: Navitgator aus PowerBI

Nun kann mit dieser Verbindung ein Report aufgesetzt werden.

Hinweis: Wird für den Datenbankbenutzer ein neues Passwort erzeugt, muss das Passwort unter den Datenquelleneinstellungen (Tab Daten->Daten transformieren->Datenquelleneinstellungen) angepasst werden.

Datenbereitstellung in Excel mittels Add-In

Das beliebte Add-In for Microsoft Excel wird ebenfalls von der Datasphere unterstützt. Vor dem Release 2.8 Version 14 konnte keine direkte Verbindung zur Datasphere hergestellt werden. Hier musste sich über das SAC Plugin auf die SAC verbunden und über die Live Daten Verbindung zwischen der SAC und der Datasphere die Daten geladen werden.

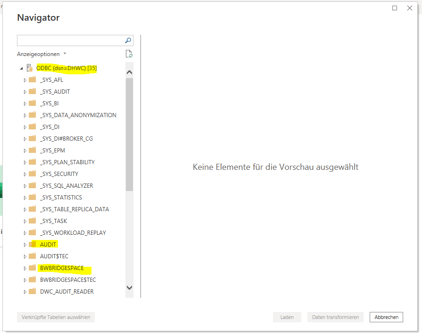

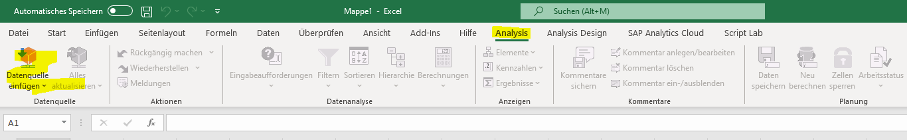

Mit der Änderung in der Version 14 ist es möglich, eine direkte Verbindung mit der SAP Datasphere und Excel herzustellen. Hierbei wird in Excel auf den Tab Analysis gewechselt.

Abbildung 22: Excel eine Übersicht

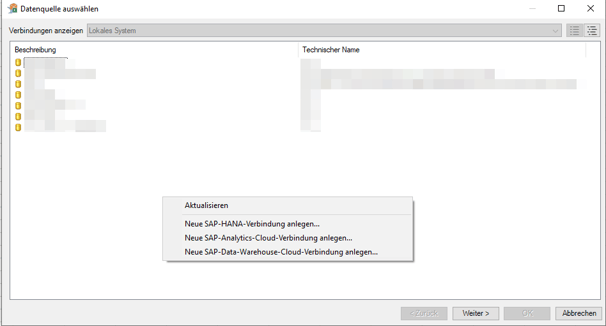

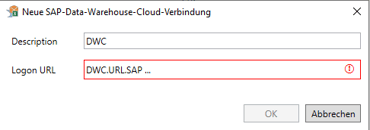

Unter Datenquellen Einfügen->Datenquelle für Analyse definieren (Anmeldefenster überspringen, kann eine neue Datasphere Verbindung angelegt werden)

Abbildung 23:Verbindungsanzeige Addin

Abbildung 24: Neue Cloudverbindung anlegen

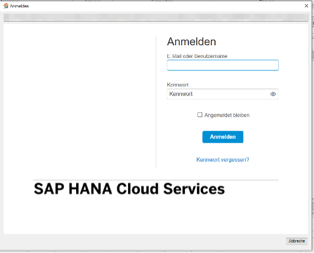

Hier kann die Login URL eingetragen werden. Beim Verbinden erscheint ein Anmeldefenster, indem der User sich mit den Zugangsdaten der Datasphere anmelden muss.

Abbildung 25: Anmeldemaske SAP Datasphere

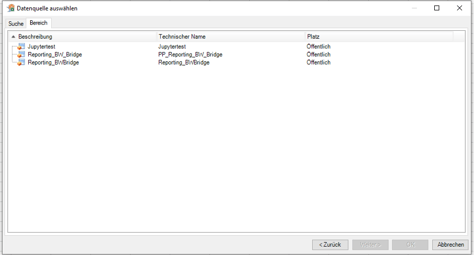

Der registrierte User kann nun alle Modelle und Views laden, die in seinem zugeordneten Space verfügbar sind und zur Verwendung freigegeben wurden.

Abbildung 26: Übersicht der verfügbaren Modelle und Views

Durch die Auswahl eines der Modelle wird der Ladeprozess angestoßen.

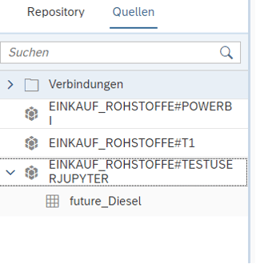

Zugriff über Jupyter Notebooks und Pandas Dataframe

Sollen Daten von Data Scientists untersucht werden, besteht auch die Möglichkeit, Daten aus der SAP Datasphere mittels Anlage eines Database Users für bspw. Jupyter Notebooks zur Verfügung zu stellen. Dabei ist es jedoch notwendig, die öffentlich IP-Adresse des zugreifenden PC, Cloud, etc. in die IP Allowlist mit aufzunehmen, da sonst der Zugriff geblockt wird. Die SAP hat hierzu eigene Algorithmen entwickelt, die es ermöglichen, einen Zugriff zu realisieren. Tabellen können entweder mit eigenen Algorithmen der SAP analysiert oder in ein Pandas Dataframe umgewandelt werden, was es erlaubt, die komplette Bandbreite an Algorithmen auf Datensätze anzuwenden, die zur Verfügung stehen. Nach der Analyse kann das Dataframe wieder in ein Hana Dataframe umgewandelt und in die Datasphere zurückgespielt werden. Dies ist allerdings nur möglich, wenn dem Datenbase User auch Schreibrechte zugeteilt wurden. Die Objekte erscheinen ebenfalls im Data Builder->View (SQL oder Grafisch)->Quellen. Hier wird für jeden Database User des Spaces eine eigene Verbindung angelegt.

Abbildung 27: Einspeisen von Tabellen nach der Analyse

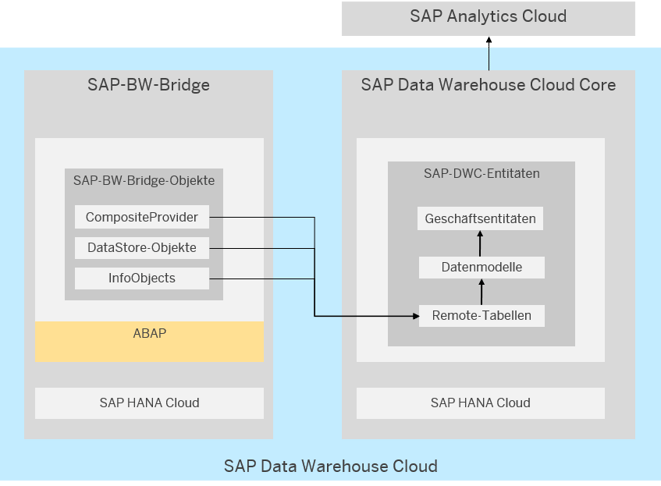

Von On-Premise in die Cloud mit der SAP BW-Bridge

Die SAP-BW-Bridge stellt den Funktionsumfang von SAP BW direkt in der SAP Datasphere bereit. Letztlich handelt es sich bei der SAP BW Bridge also um ein SAP BW-System in der Cloud.

Abbildung 28: SAP BW Bridge und SAP Datasphere

Mit SAP-BW-Bridge können also die BW typischen Konnektivitätsfunktionen einschließlich des SAP Business Contents (Extraktoren) für die Integration von Daten aus der SAP Business Suite und SAP S/4HANA verwendet werden. Daneben ist auch eine vollständige Migration eines on-prem SAP BW∕4HANA in die Cloud möglich sowie die Konvertierung einzelner Objekte aus älteren SAP BW Systemen (einschließlich der Metadaten) in SAP-BW-Bridge-Modelle.

Dafür muss in Eclipse ein BW Bridge Projekt angelegt werden. Um mit der BW Bridge allerdings arbeiten zu können, muss der User sowohl für die Datasphere als auch für die BW Bridge freigeschalten sein. Zusätzlich muss im Projekt der Service Key eingespielt werden. Dieser ist in der Datasphere unter: Space BW-Bridge->Verbindungen->Bearbeiten->Service Key kopieren und einfügen. Optional: Speichern des Service Key in einer Text-Datei und Einspielen der Datei.

Im BW Bridge Projekt muss das SAP-System als Quellsystem angelegt werden. Anschließend kann in einem BW Bridge Projekt, wie in dem bisherigen BW Projekt, DataStore Objects, Query, ABAP Codes und alle anderen bekannten ABAP Objekte angelegt werden.

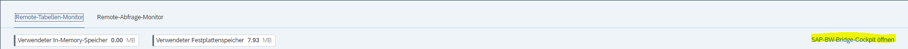

Nach der Ausführung werden ABAP Objekte über die BW Bridge übersetzt und in die Datasphere geladen.

Abbildung 28: Zugriff auf das BW-Bridge Cockpit

Fazit

Jüngst kündigte die SAP an, bestehende On-Premise Lösungen ab 2040 nicht mehr zu unterstützen. So gesehen bleiben Ihnen noch 18 Jahre Zeit für einen Wechsel. Wenn Sie also mit Ihrer bestehenden Data Warehouse Lösung zufrieden sind, gibt es wenig Gründe aktiv zu werden.

Die meisten unserer Kunden beschäftigen derzeit die Frage, wie sie mehr aus ihren SAP Daten machen können, wie sie diese mehr Nutzergruppen sicher zur Verfügung stellen können, ohne dass der Aufwand für den Betrieb und Anpassungen aus dem Ruder läuft. Letztlich beschäftigt viele die Frage, wie Fachbereiche vom Data Consumer zum Content Creator gewandelt und zukünftig selbst entscheiden können, welche Daten wem zur Verfügung gestellt werden. Stichwort Datendemokratie und Daten als Produkt.

Genau hier bietet die SAP Datasphere spannende Möglichkeiten. Durch die Organisation der Daten und Datenmodell in Spaces, der Trennung in Daten- und Business- Layer, dem integrierten Datenmarktplatz und vielversprechenden Ansätzen im Bereich des Meta-Data Managements adressiert sie genau diese Anforderungen. Sie folgt dem Trend des technologieoffenen Data Warehouses und dem Low-Code Ansatz, den viele Hersteller, u.a. Microsoft, bereits seit einigen Jahren verfolgen. Gut gefallen hat uns auch der für ein SAP Produkt relativ technologieoffene Ansatz der Datasphere. Drittprodukte wie Datenbanken, BI-Tools oder anderweitige Zugriffe, bis hin zu Werkzeugen für den Data Scientisten können einfach und sicher eingerichtet werden. So sind auch Szenarien zu realisieren, die vorher nicht oder nur über Umwege möglich waren. Mit Hilfe der SAP BW Bridge sichern Sie Ihre bisherigen Investitionen, indem Sie Ihre bisher in ABAP gebauten Modelle, einfach in die Datasphere übertragen. Weil die Software als SaaS angeboten wird, erfolgen Wartung und Betrieb durch SAP.

Leider lässt sich SAP diese konzeptionell spannende und aus unserer Sicht vielversprechende Datenplattform aktuell noch recht gut bezahlen. In der kleinsten Ausführung, noch ohne BW Bridge (256 GB SSD, 8vCPUs, 128 GB IN-Memory), soll die Datasphere bereits 51,6 T€ kosten (Zahlen beziehen sich auf den offiziellen Konfigurator der SAP, eventuelle Rabatte sind nicht berücksichtigt).

Wenn Sie mehr an einer Funktionsübersicht, Anwendungsfälle und der allgemeinen Positionierung der SAP Datasphere erfahren möchten, empfehlen wir Ihnen unsere Themenseite, sowie den Download unseres Whitepapers oder unser Experteninterview zu diesem Thema.

Tags

- Data Science & Advanced Analytics (28)

- Datenstrategie & Data Driven Enterprise (26)

- Cloud Architecture & Infrastructure (24)

- SAP Technologie (16)

- Branchenlösungen & Geschäftsprozesse (6)

- Planung & Forecasting (5)

- Cloud Technologie (3)

- Business Intelligence & Visualization (1)

- Five1 Software Solutions (1)

Ähnliche Beiträge:

Wie realistisch ist Seamless Planning mit der SAP Analytics Cloud? Der Blogbeitrag zeigt, welche technischen Hürden aktuell bestehen, wie das Q4/2025 Release mit den neuen Live Versions neue Möglichkeiten eröffnet und welche Rolle SAP Datasphere und Databricks in einer zukunftsfähigen Planungsarchitektur spielen.

Die Business Data Cloud (BDC) wurde offiziell vorgestellt und markiert eine bedeutende Veränderung in der Art und Weise, wie Unternehmen ihre SAP-Daten verwalten, analysieren und mit externen Quellen verknüpfen. Doch was bedeutet das für Unternehmen, die heute auf SAP BW oder Datasphere setzen? Welche Rolle spielt Databricks? Und wie verändert sich die SAP-Datenstrategie durch diese neue Plattform?

SAP Datasphere gewinnt an Bedeutung, besonders da SAP das BW/4HANA bis 2040 nicht mehr unterstützt. Trotz klarer Vorteile sind viele Unternehmen zögerlich. Dieser Beitrag zeigt einen klaren Fahrplan für einen risikoarmen Einstieg in die Datasphere angesichts der Unsicherheiten bei der Datenintegration.