Was bedeutet „Digitalisierung der Produktion”?

Eine besonders anwendungsorientierte Definition des Begriffes „Digitalisierung“ lieferte das Bundesministerium der Verteidigung in seinem Bericht zur Digitalen Transformation seines Geschäftsbereichs: „die zielgerichtete Identifikation und das konsequente Ausschöpfen von Potentialen, die sich aus Digitaltechnik ergeben“. (Quelle: Wikipedia )

Bezogen auf Produktionsprozesse würden wir anstelle von „Digitalisierung“ vielleicht auch vom „Internet der Dinge“ (eng. „Internet of Things“ - IoT) sprechen oder von „Industrie 4.0“. Dabei geht es darum, physikalische und virtuelle Gegenstände so miteinander zu vernetzen und zusammenarbeiten zu lassen, dass sich neue technisch-organisatorische Lösungsmöglichkeiten ergeben, wodurch betriebliche Abläufe schneller und kostengünstiger abgewickelt werden können.

Bestandteile einer digitalisierten Produktion sind (ohne Anspruch auf Vollständigkeit): Sensoren an Maschinen, „digitale Zwillinge“ von Prozessen und Maschinen, Geschäftsdaten, Planungsdaten, Steuerelemente, Datenbanken, Analysetools, Schnittstellen, die Daten zurück in die physische Welt spielen, große unstrukturierte Datenmengen, Dokumentationen, Log-Files, …

Was sind die Hindernisse für Digitalisierung?

Aus unserer gegebenen Definition für eine „digitalisierte Produktion“ ergibt sich ein scheinbarer Widerspruch, der, ungelöst, häufig der Grund dafür ist, dass Unternehmen daran scheitern, Ihre Produktion konsequent und erfolgreich zu digitalisieren:

-

Einerseits handelt es sich um einen kontinuierlichen und agilen Prozess in dessen Verlauf das größte Potential vielleicht erst noch entdeckt wird, also zu Beginn noch nicht bekannt ist.

-

Andererseits erweckt die Liste der Bestandteile einer digitalisierten Produktion den Eindruck, dass ein hoher initialer Aufwand (Geld, Zeit, neue IT-Infrastruktur) schon zu Beginn des Digitalisierungsprozesses notwendig sind.

Versucht man die Ramp-Up Kosten um jeden Preis gering zu halten, kann dies zur Folge haben, dass die entwickelte Infrastruktur zu limitiert oder unflexibel ist. Als Folge ergeben sich Probleme dabei, die entwickelten Methoden und Technologien auf die ganze Produktion auszuweiten oder sinnvoll anzupassen und zu verbessern. Häufig kommt ein hoher Zeitaufwand hinzu, sowohl bei der Entwicklung als auch bei der folgenden Wartung der Systeme!

Wie hilft die AWS Cloud bei der Bewältigung dieser Hindernisse?

Innerhalb der AWS Cloud kann hoch komplexe, auf den Anwendungsfall zugeschnittene Infrastruktur aus einer Hand entwickelt werden. Ob Speicherplatz, Rechenleistung, Entwicklungsumgebungen oder Schnittstellen zu bestehender IT-Infrastruktur oder Maschinen; die Services können reibungslos ineinander integriert und in ihrer Leistung bedarfsgerecht skaliert werden. Dadurch wird ermöglicht, innerhalb sehr kurzer Zeit die notwendige Infrastruktur kostengünstig zu entwickeln, im kleinen Maßstab zu testen und anschließend auf beliebige Größe auszuweiten und produktiv einzusetzen.

Möglich wird dies unter anderem dadurch, dass AWS Ihnen Infrastruktur-, Platform- und Software- „as a Service“ anbietet, wodurch der Aufwand die Systeme (physisch und Software) zu betreiben und zu warten minimiert wird und gleichzeitige die Verfügbarkeit erhöht wird. Daraus folgt, dass mehr Zeit und Ressourcen für die Weiterentwicklung, Tests und Betriebsüberführung bleiben und damit der Nutzen der Digitalisierung für Ihrer Produktion gesteigert wird.

Wie kann die "Digitalisierung der Produktion in der AWS Cloud durchgeführt werden?

-

Konsolidierung verfügbarer Daten (nicht unbedingt alle aus allen verfügbaren Quellen, sondern genug für erste Tests)

-

Explorative Datenanalyse zur Ermittlung von Potentialen

-

Ausschöpfung des Potentials durch erste Prototypen: Digitale Twins, ML, Optimierung, Vorhersagen, Verfügbarmachen für Analysten durch geeignete Infrastruktur

-

Test und Evaluierung des Prototyps

-

Reibungslose Ausweitung auf weitere Maschinen und Prozesse und Erweitern der Funktionalitäten (zurück zu Schritt 1)

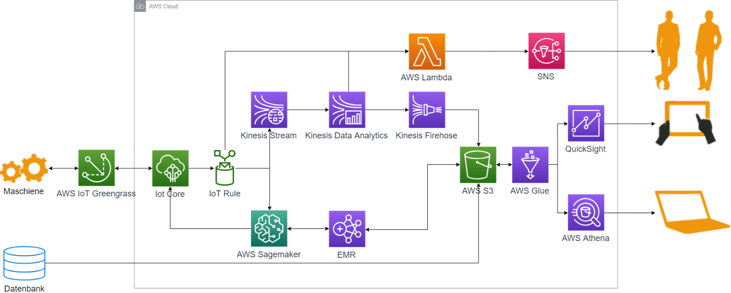

Abbildung zeigt eine Beispiel-Architektur

Erhöhung der Transparenz der Wertschöpfungskette (Archivierung, Konsolidierung & Analyse von Daten, Erhöhung der Verfügbarkeit von Informationen)

AWS S3 steht für „Simple Storage Solution“. S3 ist eine von AWS gemanagte Data-Lake-Lösung, in der strukturierte und unstrukturierte Daten aus Ihrer Produktion (Sensordaten, Log Daten, Waren- ein und Ausgänge) gesammelt werden können. Kombiniert mit der Metadatenmanagement und ETL-Lösung „AWS Glue“ kann auf S3 effizient und schnell aus einer Vielzahl weiterer AWS Services zugegriffen werden und zusätzlich automatisierte ETL Jobs eingerichtet werden um die Daten aufzubereiten und anzureichern (z. B. mit Planungsdaten).

RDS und Redshift sind zwei von AWS gemanagte Datenbank-Lösungen, die auch zur Analyse eingesetzt werden können und die Möglichkeit, externe Datenquellen anzubinden, erweitern.

Mit „AWS Athena“ können einfach Ad-hoc Analysen mit SQL-Presto auf den gesammelten Daten durchgeführt werden. Für die Erstellung Interaktiver Dashboards stellt Amazon „QuickSight“ zur Verfügung, damit Sie und alle Mitarbeiter in quasi Echtzeit den aktuellen Zustand Ihrer Produktion einsehen können. Mit AWS Sns Notifications können automatisch Email Benachrichtigungen verschickt werden, sei es für regelmäßige Reports oder um z. B. auf Anomalien in der Produktion aufmerksam zu machen.

Intelligentere Datennutzung zur Steigerung der Effizienz von Menschen und Maschinen (Maschine Learning, Predictive Maintenance, Forecasting,, Anaomaliedetektion, Steuerung)

Gerade für den Bereich der IoT bietet AWS eine ganze Palette an Services an. IoT Greengrass und IoT Core beispielsweise sind Schnittstellen, um IoT-Geräte in großer Zahl mit der AWS Cloud zu verbinden. Dabei handelt es sich nicht nur um einfaches Sammeln von Daten; „Device Shadows“ sind virtuelle Repräsentation Ihrer Maschinen und den Abhängigkeiten zwischen ihnen. Durch die „Rule Engine“ können die gelieferten Daten direkt ausgewertet und entsprechende Aktionen durchgeführt werden.

Durch die Services AWS Kinesis Streams, - Data Analytics und -Data Firehose können Daten gestreamt, dass heißt in Echtzeit eingelesen und analysiert werden, was besonders für zeitkritische Steuerungs- und Überwachungsprozesse von enormer Bedeutung ist.

Amazon Sagemaker, AWS Machine Learning und AWS EMR stellen skalierbare Datenanalyse-Platformen zur Verfügung. Sie eignen sich besonders für komplexe Datenanalysen und Rechen- und Speicherplatz-intensive Aufgaben wie Maschine Learning für Forecasting oder Anomaliedetektion. Sie bieten eine attraktive Entwicklungsumgebung für die Analysten und können gleichzeitig für die voll automatisierte Verarbeitung von Daten eingesetzt werden.

Wenn Sie selbst aktuell vor der Frage stehen, wie Sie Ihre Berichte künftig umsetzen sollen oder Fragen zur AWS Cloud haben, kommen Sie gerne auf uns zu. Wir schauen uns Ihre Situation ganz individuell an und prüfen mit Ihnen gemeinsam, was die beste Strategie für Sie ist.

Weitere Informationen finden Sie in unserem AWS Consulting Services Flyer.

Tags

- Data Science & Advanced Analytics (28)

- Datenstrategie & Data Driven Enterprise (26)

- Cloud Architecture & Infrastructure (24)

- SAP Technologie (16)

- Branchenlösungen & Geschäftsprozesse (6)

- Planung & Forecasting (5)

- Cloud Technologie (3)

- Business Intelligence & Visualization (1)

- Five1 Software Solutions (1)

Ähnliche Beiträge:

Erfahren Sie mehr über die 6 häufigsten Irrtümer beim Aufbau eines Data Lakes. Unser Artikel beleuchtet die Organisation unstrukturierter Daten, die Bedeutung von Metadaten und die kontinuierliche Entwicklung der Datenplattform. Entdecken Sie klare Standards, Automatisierung und Teamkommunikation für einen erfolgreichen Data Lake. Erfahren Sie mehr in unserem E-Book 'Lakehouse Automation'.