Kriterien für die Auswahl einer zukunftsfähigen Lösung

Im vorangegangenen Blog haben wir uns mit der grundsätzlichen Frage beschäftigt, wie viele Datenkataloge in einem Unternehmen nötig sind und mit dem Mythos aufgeräumt, ein Datenkatalog könne alle Probleme der Datenhaltung lösen. Nun beschäftigen wir uns etwas konkreter mit der Frage, welcher Datenkatalog der Richtige ist und welche Kriterien bei der Auswahl eine Rolle spielen können oder sollten.

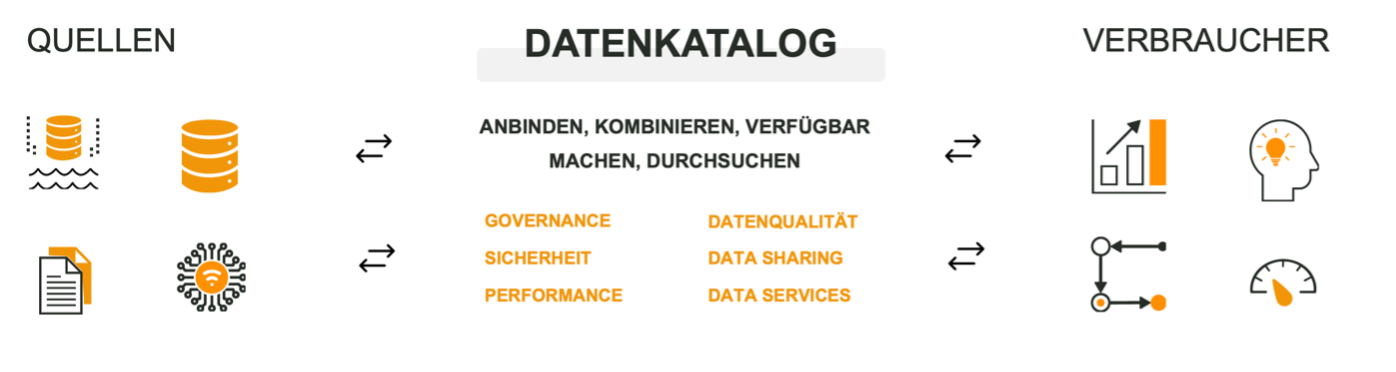

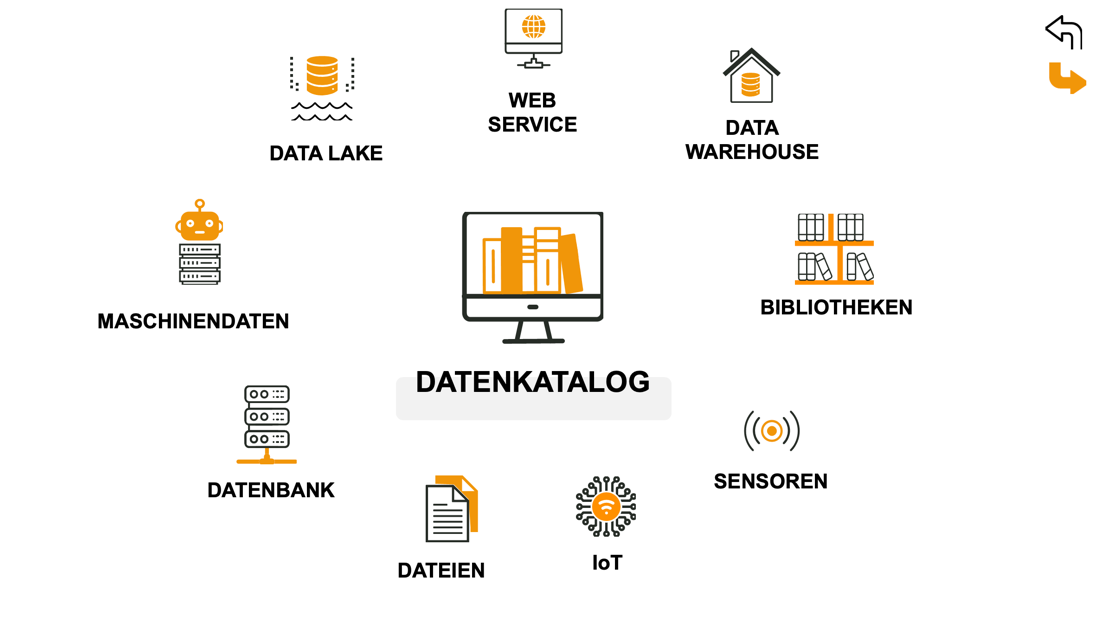

Zu einem vollständigen Datenkatalog gehören eine Vielzahl von Funktionalitäten, teils mit grundlegenden Aufgaben für die Datenhaltung. Einfache Datenkataloge oder Teilfunktionalitäten eines Datenkatalogs sind daher in vielen Produkten aus den Bereichen Datenspeicherung und Datenverarbeitung bereits enthalten. Einige Produkte positionieren sich dagegen gezielt als reiner Datenkatalog, der sich als Katalog-Layer über andere Systeme legt.  Im Folgenden soll es nur um Datenkataloge gehen, aber zusätzliche Bestandteile der Produkte und die Integration spielen für die Entscheidung natürlich ebenso eine Rolle. Schauen wir uns die wichtigsten Aspekte für die Auswahl eines Datenkatalogs an.

Im Folgenden soll es nur um Datenkataloge gehen, aber zusätzliche Bestandteile der Produkte und die Integration spielen für die Entscheidung natürlich ebenso eine Rolle. Schauen wir uns die wichtigsten Aspekte für die Auswahl eines Datenkatalogs an.

Die technische Basis vieler Datenkataloge sind Open Source Technologien mit proprietären Weiterentwicklungen und Verbesserungen. Zumeist kommen Apache Hive, Apache Ranger und Apache Atlas zum Einsatz. Die kommerziellen Angebote sind üblicherweise gemanagte Lösungen mit Verwaltung durch den Anbieter und werden auf Infrastruktur von Anbieter (Public Cloud, Private Cloud) oder Kunde (Public Cloud, Private Cloud, On-Premise) betrieben. Ist On-Premise-Einsatz Pflicht reduziert sich die Anbieterauswahl bereits stark (z.B. Ataccama). Zwischen den Extremen Public Cloud und On-Premise gibt es allerdings vielfältige Zwischenstufen für fast jeden Einsatzfall.

Eine weitere grundlegende technische Frage gilt den Datenquellen: Welche Datenquellen sollen mit welchem Datenvolumen eingebunden werden? Die Angebote der großen Cloudprovider (AWS Glue, Azure Data Catalog, GCP Data Catalog) sind naturgemäß auf eine Cloud festgelegt. Die anderen Anbieter geben sich Mühe, möglichst viele Datenquellen in den Katalog einzubinden und cross-cloud und multi-cloud fähig zu sein. Ebenso lassen sich in der Regel Datenquellen On-Premise auch in Cloudangeboten anbinden. Bei großen Datenvolumina können Kataloge basierend auf Datenvirtualisierung (z.B. Denodo) oder Verarbeitungsfunktionen (z.B. Starburst) Performancevorteile bieten.  Je nach Einsatzzweck und -umgebung des Datenkatalogs kommt der Integration in vorhandene Systeme eine große Bedeutung zu. Die Kataloge der Cloudprovider lassen sich tief in die jeweilige Cloudumgebung integrieren. Ähnlich gut integriert sind die Kataloge der großen Datenplattformen (z.B. Databricks Data Catalog, Databricks Unity Catalog, SAP Data Intelligence Data Catalog, SAP Data Warehouse Cloud).

Je nach Einsatzzweck und -umgebung des Datenkatalogs kommt der Integration in vorhandene Systeme eine große Bedeutung zu. Die Kataloge der Cloudprovider lassen sich tief in die jeweilige Cloudumgebung integrieren. Ähnlich gut integriert sind die Kataloge der großen Datenplattformen (z.B. Databricks Data Catalog, Databricks Unity Catalog, SAP Data Intelligence Data Catalog, SAP Data Warehouse Cloud).

Letzten Endes sollen verschiedene Nutzer den Datenkatalog verwenden. Vom Fachanwender zum Entwickler unterscheiden sich die Anforderungen dabei stark. Für alle Nutzer ist jedoch ein anwenderfreundliches UI (User Interface) und UX (User Experience) wichtig. Fachanwender benötigen meist eine einfach zu bedienende (Web-)Oberfläche, durch die man schnell an die gewünschten Informationen kommt (z.B. Alation, Immuta). Für technische Projekte ist dagegen nur eine einfache oder manchmal gar keine Oberfläche nötig (z.B. AWS Glue).

Zum UX gehört eine gute, und vor allem intuitive, Suchfunktion. Der primäre Zweck eines Datenkatalogs ist Daten bereitzustellen und für andere Nutzer oder Dienste verfügbar zu machen. Dieser Zweck lässt sich nicht erfüllen, wenn Daten nicht schnell und einfach gefunden werden. Für weniger technikaffine Nutzer kann eine Suche mit natürlicher Sprache dabei sehr hilfreich sein (z.B. Alation).

Wenn er richtig eingesetzt wird, ist ein Datenkatalog ein reichhaltiger Supermarkt für Daten. Daher sollte er eine Self-service Mentalität umsetzen. Nach der erfolgreichen Suche bedeutet das, Daten müssen sich leicht im jeweils benötigten Format anwenden lassen, beispielsweise per Verlinkung zu PowerBI, als Excel-Download oder Verbindungsdaten für den zuständigen Datenbankserver. Im gesamten Prozess muss die Bedienung, die Daten selbst, sowie Metadaten selbsterklärend sein oder erklärt werden. Nicht alle Nutzer haben den gleichen Hintergrund und selbst wenn doch, verstehen zwei Personen selten das Gleiche unter einem Begriff. Für diese Fälle hilft ein integriertes Business-Glossar für Fachbegriffe, das zum Beispiel Tabellenspalten oder Beschreibungen präzisiert (z.B. Alation, Ataccama, SAP Data Intelligence).

Viele Anbieter statten ihre Datenkataloge mittlerweile mit KI-Unterstützung aus (z.B. Ataccama, BigID, Collibra). Diese Entwicklung kann die Selbstverwaltung fördern, indem manuelle Arbeit oder technische Details von KI übernommen werden. Beispiele sind automatisches Tagging der Daten (Versehen mit Etiketten zum Auffinden oder Klassifizieren), Erkennen von schützenswerten, privaten oder persönlichen Daten oder die Erstellung von Metadaten wie Beschreibungen. In Folge gewinnt der Datenkatalog an Qualität und wird einfacher zu bedienen, wodurch sich die Zufriedenheit der Anwender und die Adoptionsrate erhöhen.

Wie die vorigen Aspekte aus Sicht der Anwender, ist ebenso die Perspektive von Administratoren zu berücksichtigen. Ein passend dimensioniertes und ausgestattetes Berechtigungsmanagement ist für den Einsatz unabdingbar. Ein unternehmensweiter Datenkatalog (z.B. in einem Data Mesh) erfordert ein umfassendes Berechtigungssystem, während für einen spezialisierten Katalog (z.B. Datenverwaltung innerhalb einer Pipeline) ein einfacheres Berechtigungskonzept ausreicht. Unterschiedliche Ansätze, wie föderierte Governance oder hierarchische Berechtigungen, müssen vom Datenkatalog unterstützt werden. Einzelne Anbieter legen ihren Fokus daher gezielt auf umfangreiche Möglichkeiten bei Governance und Sicherheit (z.B. Immuta, BigID).

Für den Betrieb jedes informationsverarbeitenden Systems sind Logging und Auditing von Bedeutung. Nachverfolgbarkeit von Abläufen ist die Bedingung für Fehlerbehebung und Monitoring, aber auch um die Einhaltung von Richtlinien nachzuweisen (z.B. DSGVO). Je nach Daten, Anwendung und Nutzerschaft ist auf das richtige Maß und die notwendigen Funktionalitäten zu achten.

Bei allem bislang genannten handelt es sich in erster Linie um technische Aspekte eines guten Datenkatalogs. Entscheidend für den erfolgreichen Einsatz im Unternehmen ist jedoch die tatsächliche Verwendung und Pragmatismus. Das tollste Tool nützt nichts, wenn es nicht verwendet wird! Zum Einstieg ist es daher sinnvoll, mit niederschwelligen Angeboten zu starten, anstatt gleich einen komplexen Prozess einzuführen. So darf es zum Start gerne eine kuratierte Excel-Tabelle der Datensätze, ergänzt durch Definitionen und Erklärungen, sein. Zeigt sich der Mehrwert dieses Katalogs in der Praxis, kommen Wünsche der Mitarbeiter nach mehr Umfang und Funktion ganz schnell von selbst. Dann ist es sinnvoll, eine Lösung zu wählen, die in der Lage ist, mit den Anforderungen "zu wachsen"...

Diese schon recht umfangreiche Liste deckt nur einen Teil der Aspekte ab, die die Auswahl eines Datenkatalogs beeinflussen können. Ebenso ist die Liste der verfügbaren Anbieter und Produkte deutlich länger als die hier erwähnten Beispiele. Die Auswahl des optimalen Datenkatalogs für Ihren Einsatzfall unter den gegebenen Rahmenbedingungen kann also komplex ausfallen. Lassen Sie uns sprechen, wir unterstützen Sie gerne.

Tags

- Data Science & Advanced Analytics (28)

- Datenstrategie & Data Driven Enterprise (26)

- Cloud Architecture & Infrastructure (24)

- SAP Technologie (16)

- Branchenlösungen & Geschäftsprozesse (6)

- Planung & Forecasting (5)

- Cloud Technologie (3)

- Business Intelligence & Visualization (1)

- Five1 Software Solutions (1)

Ähnliche Beiträge:

Erfahren Sie mehr über die 6 häufigsten Irrtümer beim Aufbau eines Data Lakes. Unser Artikel beleuchtet die Organisation unstrukturierter Daten, die Bedeutung von Metadaten und die kontinuierliche Entwicklung der Datenplattform. Entdecken Sie klare Standards, Automatisierung und Teamkommunikation für einen erfolgreichen Data Lake. Erfahren Sie mehr in unserem E-Book 'Lakehouse Automation'.